Selama beberapa bulan terakhir, komunitas kecerdasan buatan telah dilanda perdebatan sengit yang dipicu oleh dua makalah penelitian berpengaruh yang diterbitkan oleh Apple. Yang pertama, ilusi-pemikiran-debat-yang-mengguncang-dunia-ai&_bhlid=a540c17e5de7c2723906dabd9b8f31cdf0c5bf18" target="_blank" id="">"GSM-Simbolik" (Oktober 2024), dan yang kedua, "Ilusi Pemikiran" (Juni 2025), mempertanyakan kemampuan penalaran yang diduga dari Model Bahasa Besar, yang memicu reaksi beragam di seluruh industri.

Seperti yang telah dianalisis dalam pembahasan kami sebelumnya tentang "Ilusi Kemajuan: Mensimulasikan Kecerdasan Buatan Umum Tanpa Mencapainya", masalah penalaran buatan menyentuh inti dari apa yang kita anggap sebagai kecerdasan dalam mesin.

Para peneliti Apple melakukan analisis sistematis pada Large Reasoning Models (LRM ) - model-model yang menghasilkan jejak penalaran yang mendetail sebelum memberikan jawaban. Hasilnya mengejutkan dan, bagi banyak orang, mengkhawatirkan.

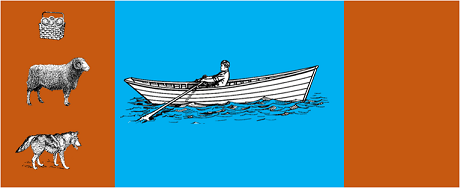

Penelitian ini menggunakan model yang paling canggih untuk memecahkan teka-teki algoritmik klasik seperti:

Hasil penelitian menunjukkan bahwa perubahan kecil dalam perumusan masalah menyebabkan variasi yang signifikan dalam kinerja, yang menunjukkan kerapuhan yang mengkhawatirkan dalam penalaran. Seperti yang dilaporkan dalam Cakupan AppleInsider"performa semua model menurun ketika hanya nilai numerik dalam soal benchmark GSM-Symbolic yang diubah".

Tanggapan dari komunitas AI tidak lama datang. Alex Lawsen dari Open Philanthropy, berkolaborasi dengan Claude Opus dari Anthropic, menerbitkan sebuah bantahan terperinci yang berjudul "Ilusi Pemikiran".yang menentang metodologi dan kesimpulan dari studi Apple.

Ketika Lawsen mengulangi pengujian dengan metodologi alternatif - meminta model-model tersebut untuk menghasilkan fungsi rekursif alih-alih membuat daftar semua gerakan - hasilnya sangat berbeda. Model seperti Claude, gemini, dan GPT dengan tepat memecahkan masalah Menara Hanoi dengan 15 catatan, jauh melampaui kerumitan di mana Apple melaporkan tidak ada keberhasilan.

Gary Marcusseorang kritikus lama terhadap kemampuan penalaran LLM, menerima temuan Apple sebagai konfirmasi dari tesisnya selama 20 tahun. Menurut Marcus, para LLM terus berjuang dengan 'pergeseran distribusi' - kemampuan untuk menggeneralisasi di luar data pelatihan - sambil tetap menjadi 'pemecah masalah yang baik untuk masalah yang telah dipecahkan'.

Diskusi ini juga telah menyebar ke komunitas-komunitas khusus seperti LocalLlama di Redditdi mana para pengembang dan peneliti memperdebatkan implikasi praktis untuk model sumber terbuka dan implementasi lokal.

Perdebatan ini tidak murni akademis. Ini memiliki implikasi langsung terhadap:

Seperti yang disorot dalam beberapa wawasan teknisada peningkatan kebutuhan akan pendekatan hibrida yang menggabungkan:

Contoh sepele: asisten AI yang membantu pembukuan. Model bahasa mengerti ketika Anda bertanya "berapa banyak yang saya habiskan untuk perjalanan bulan ini?" dan mengekstrak parameter yang relevan (kategori: perjalanan, periode: bulan ini). Tetapi kueri SQL yang menanyakan database, menghitung jumlah dan memeriksa batasan fiskal? Itu dilakukan oleh kode deterministik, bukan model neural.

Tidak luput dari perhatian para pengamat bahwa makalah Apple diterbitkan tidak lama sebelum WWDC, sehingga menimbulkan pertanyaan tentang motivasi strategis. Sebagaianalisis oleh 9to5Mac"waktu penerbitan makalah Apple - tepat sebelum WWDC - menimbulkan beberapa pertanyaan. Apakah ini merupakan tonggak penelitian, atau langkah strategis untuk memposisikan ulang Apple dalam lanskap AI yang lebih luas?"

Perdebatan yang dipicu oleh makalah Apple mengingatkan kita bahwa kita masih berada di tahap awal dalam memahami kecerdasan buatan. Seperti yang ditunjukkan dalam artikel kami sebelumnyaperbedaan antara simulasi dan penalaran otentik tetap menjadi salah satu tantangan paling kompleks di zaman kita.

Pelajaran yang sebenarnya bukanlah apakah LLM dapat 'bernalar' dalam pengertian manusia atau tidak, melainkan bagaimana kita dapat membangun sistem yang dapat mengeksploitasi kekuatannya sekaligus mengimbangi keterbatasannya. Di dunia di mana AI telah mengubah seluruh sektor, pertanyaannya bukan lagi apakah alat ini 'pintar', tetapi bagaimana menggunakannya secara efektif dan bertanggung jawab.

Masa depan AI perusahaan mungkin tidak akan terletak pada satu pendekatan revolusioner, tetapi pada orkestrasi cerdas dari beberapa teknologi yang saling melengkapi. Dan dalam skenario ini, kemampuan untuk mengevaluasi kemampuan alat kita secara kritis dan jujur menjadi keunggulan kompetitif itu sendiri.

Perkembangan Terkini (Januari 2026)

OpenAI merilis o3 dan o4-mini: Pada 16 April 2025, OpenAI secara resmi merilis o3 dan o4-mini, model penalaran paling canggih dalam seri o. Model-model ini kini dapat menggunakan alat secara agen, menggabungkan pencarian web, analisis file, penalaran visual, dan pembangkitan gambar. o3 telah menetapkan rekor baru pada benchmark seperti Codeforces, SWE-bench, dan MMMU, sementara o4-mini mengoptimalkan kinerja dan biaya untuk tugas-tugas penalaran volume tinggi. Model-model ini menunjukkan kemampuan "berpikir dengan gambar", mengubah konten secara visual untuk analisis yang lebih mendalam.

DeepSeek-R1 mengguncang industri AI: Pada Januari 2025, DeepSeek merilis R1, sebuah model penalaran open-source yang mencapai kinerja setara dengan OpenAI o1 dengan biaya pelatihan hanya $6 juta (dibandingkan dengan ratusan juta dolar untuk model-model Barat). DeepSeek-R1 membuktikan bahwa kemampuan penalaran dapat ditingkatkan melalui reinforcement learning murni, tanpa memerlukan demonstrasi manusia yang dianotasi. Model ini menjadi aplikasi gratis #1 di App Store dan Google Play di puluhan negara. Pada Januari 2026, DeepSeek menerbitkan makalah 60 halaman yang mengungkapkan rahasia pelatihan dan secara jujur mengakui bahwa teknik seperti Monte Carlo Tree Search (MCTS) tidak berhasil untuk penalaran umum.

Anthropic memperbarui "Konstitusi" Claude: Pada 22 Januari 2026, Anthropic menerbitkan konstitusi baru berisikan 23.000 kata untuk Claude, beralih dari pendekatan berbasis aturan ke pendekatan berbasis pemahaman prinsip-prinsip etika. Dokumen ini menjadi kerangka kerja pertama dari perusahaan AI besar yang secara resmi mengakui kemungkinan kesadaran atau status moral AI, dengan menyatakan bahwa Anthropic peduli terhadap "kesejahteraan psikologis, rasa diri, dan kesejahteraan" Claude.

Debat semakin memanas: Sebuah studi pada Juli 2025 telah mengulang dan menyempurnakan tolok ukur Apple, mengonfirmasi bahwa LRM masih menunjukkan keterbatasan kognitif saat kompleksitas meningkat secara moderat (sekitar 8 cakram dalam Menara Hanoi). Para peneliti menunjukkan bahwa hal ini tidak hanya bergantung pada batasan output, tetapi juga pada keterbatasan kognitif yang sebenarnya, menyoroti bahwa debat ini jauh dari selesai.

Untuk mendapatkan wawasan tentang strategi AI organisasi Anda dan implementasi solusi yang kuat, tim ahli kami siap memberikan konsultasi khusus.